Hace poquito en el diario El país salió una nota de Raúl Limón sobre los nuevos avances en inteligencia artificial liderados por Google DeepMind y OpenAI. Parece que el formato conversacional, el de los famosos chatbots como el de GPT, ya pasó al nivel de lo común, y ahora los agentes de IA no solo responden preguntas en cuadritos de texto, sino que hacen cosas. Los nuevos asistentes pueden llevar adelante procesos completos, dividiéndolos en pequeñas tareas: desde analizar un video y dar feedback hasta ofrecer soluciones y ejecutarlas. Pongo un ejemplo: en vez de pedirle al asistente de IA que te diga de qué trata un libro, le podés pedir que lo compare con otros libros similares y te diga cuál es mejor para enseñar en tu clase, te arme un powerpoint sobre el tema central de la unidad, mande un mail a tus estudiantes con el ppt junto a una consigna de lectura previa al encuentro y, de ser necesario, se ocupe de responder los mails de consultas. Así, todo: le podés pedir que te compre ropa en base a tu estilo personal, que gestione la devolución de algún producto, que eleve una queja a un proveedor de servicios, que te diga qué decisión laboral es más conveniente tomar.

Un asistente hecho y derecho, por la módica suma de USD 20 por mes. Suena a ganga, pero el precio real es otro: en principio, tus datos. Para que el asistente funcione al máximo, le tenés que dar acceso a tu cuenta de mails, documentos, fotos, archivos, contactos y demás. Me tienta el nivel de facilidad que tendría mi vida con la ayuda de alguien… perdón, algo que haga tantas cosas por mí. Pero ¿cuáles son los límites?

Pensemos no solo en los problemas de alcance individual, sino también social. Acá la privacidad no es el único costo. Supongamos que tenemos que contratar a una persona para hacer un trabajo y le pedimos al agente de IA que nos ayude a elegir entre tres candidatxs. ¿Qué consejo nos va a dar y en base a qué criterios?

En la nota de El país, se enumeran las ventajas más evidentes de la asistencia personalizada, pero también se exponen los riesgos. Estos robots pueden:

interpretar equivocadamente los intereses de lxs usuarixs

llegar a conclusiones a partir de fuentes de información imprecisas o falsas

priorizar soluciones a corto plazo por sobre las de largo plazo

vulnerar la privacidad

dar respuestas nocivas para lx usuarix

guiarse por los intereses de los desarrolladores, que pueden ser preeminentemente económicos

imponer valores a la sociedad y crear corrientes de opinión

participar de campañas maliciosas de ataques informáticos

La sociedad está siendo moldeada por la gobernanza algorítmica. En gran parte del mundo, los sistemas de toma de decisiones automáticos y algorítmicos gobiernan varios aspectos de nuestras vidas. Y esto es posible porque tendemos a pensar que la tecnología es objetiva y le hacemos caso sin cuestionarla. Peor aún, creemos que sí la cuestionamos cuando criticamos los famosos “sesgos” (o “bias”, en inglés).

Cuando el ChatGPT decía que para bajar de peso el hombre tenía que hacer ejercicio y la mujer tenía que hacerse una cirugía estética, estaba incurriendo en un “sesgo” de género. Está lleno de campañas, organizaciones, piezas comunicativas que denuncian este tipo de problemas en tecnología y que se proponen combatirlos. Sin embargo, no los definen con precisión. La misma vaguedad terminológica recorre el mundo científico, donde es fácil encontrar papers1 que usan como sinónimos “sesgo”, “error”, “discriminación”, “prejuicio”, “estereotipo”, “estigma”, todos conceptos muy distintos entre sí que en diferentes disciplinas sociales y humanísticas fueron discutidos y definidos con profundidad. Vamos, entonces, a hacer una breve disección.

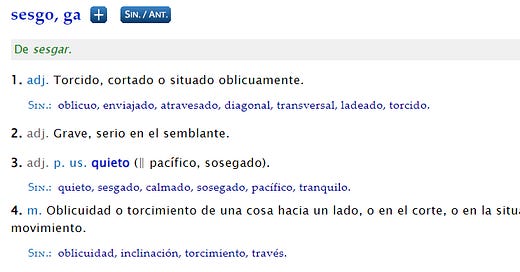

La palabra “sesgo” se usa en Estadística para referir a la tendencia de algunos métodos de recolección de datos que incurren en errores o inexactitudes a la hora de representar la realidad.2 En el mundo no técnico, el diccionario de la Real Academia Española entiende “sesgo” como un adjetivo (?) que significa “torcido, cortado o situado oblicuamente”, y un sustantivo que significa “torcimiento”. Wikipedia coincide en que el sustantivo significa “inclinación, oblicuidad”, y WordReference incluye sinónimos como “través” y “desviación”.

Lo de “cortado” puede expresar un recorte poblacional que redunda en la subrepresentación de grupos minorizados en cuanto al género, racialización, estrato socioeconómico, geografía y demás. Pero en el ejemplo de bajar de peso no solo se está subrepresentando uno o varios géneros, sino que se están ofreciendo soluciones distintas en función de un criterio cultural. ¿De dónde surge este criterio? Podría salir de una base de datos sobre qué suelen googlear las mujeres cuando quieren bajar de peso, o -más polémico- qué suelen recomendar lxs médicos a las personas que quieren bajar de peso. Testimonios sobre recomendaciones desiguales (“¿desviadas?”) por parte del personal de salud hay de sobra, como muestra la última campaña de la Fundación Bellamente por el Día Internacional de la Salud Mental. Entonces, ¿qué hacemos con esos datos?

Entender el sesgo como algo torcido abona la idea de que se trata de un desvío de aquello que se está mostrando (en un texto, gráfico, imagen) sobre alguna porción del mundo. Pero el hecho de que las recomendaciones que ChatGPT ofrece a las personas según su género son diferentes y que suelen perjudicar a las mujeres y omitir a las personas LGBTI, ¿es realmente un desvío con respecto a nuestra realidad social? ¿La IA le está fallando a la representación de la sociedad o la está copiando fielmente? Lo cierto es que gran parte de los problemas que el mundo tech entiende como “sesgos” tienen su raíz en desigualdades sociales preexistentes. Y acá es donde la Sociología nos puede ayudar.

En un grupo de estudio sobre IA y sociolingüística leímos el artículo Artificial intelligence, algorithms, and social inequality… publicado en 2022 por el sociólogo Mike Zajko. Su punto de partida es que los discursos actuales sobre tecnología algorítmica suelen compartir una idea de inevitabilidad y de determinismo tecnológico (¡no hay nada que hacer!); mientras que aumenta la preocupación por la pérdida de la agencia humana (¡los robots nos reemplazarán!). Pero estas alarmas desvían el foco de atención de un problema crucial sobre el que hay mucho por hacer: los “sesgos” que hay en nuestra sociedad son reproducidos por los sistemas automatizados. Y no se trata solo de una repetición del “desvío” humano, sino de una multiplicación a gran escala: el aprendizaje automático y la gobernanza algorítmica suelen crear “feedback loops” (bucles de retroalimentación) que replican y amplifican los patrones existentes en la sociedad.

Si bien lxs profesionales de IA suelen abordar este problema con la palabra “sesgo”, este último concepto no es útil para entender cómo lidiar con las desigualdades preexistentes a los desarrollos tecnológicos, desigualdades que no se deben a errores de medición o de datos. Por eso, para resolverlo vienen intentando remover, reducir o minimizar los sesgos en los datasets y en las decisiones algorítmicas, sin darse cuenta de que eso que llamamos sesgo es discriminación y no puede ser abordado solamente con soluciones tecnológicas.

Tenemos, acá, un conflicto de intereses que descansa justamente en qué entendemos por “sesgo”. Zajko recupera dos problemas al respecto. Por un lado, la excesiva simplificación suele desconocer los diferentes tipos de sesgo y sus raíces profundas. Así, por ejemplo, la expresión de desigualdades sociales suele ser entendida como “sesgo social” o “sesgo histórico”. El efecto de esta etiqueta es encerrar en una caja negra toda especificidad sobre el origen y el carácter estructural de tal “sesgo”. Desde las ciencias sociales, en cambio, las estructuras de desigualdad, opresión y explotación que dan lugar a tales sesgos tienen nombres concretos: colonialismo, heteropatriarcado, capacitismo, supremacía blanca y varias articulaciones de capitalismo y economía política. Por otro lado, todavía no hay consenso sobre qué es o cómo debería ser un algoritmo “justo” o “no sesgado”, o incluso si es posible que exista o no.

A grandes rasgos, podemos encontrar dos maneras distintas de entender los sesgos, según cómo se relacionan con “la realidad”. Lxs desarrolladorxs de IA suelen hablar de “ground truth” (¿verdad fundamental?, ¿la posta?) cuando se refieren a la realidad que se encuentra fuera de los modelos de IA; el sesgo, como vimos arriba, suele ser definido como los desvíos con respecto a esa verdad, es decir, como predicciones y representaciones imprecisas de la realidad. Una segunda definición es un poco más amplia y ya no concibe el sesgo como un error o desvío, sino como aquello que puede ser indeseable en una sociedad. Acá, el conflicto.

Consideremos “la realidad” de nuestra sociedad: las desigualdades y las injusticias son profundas y estructurales. Si un modelo de IA reproduce esta realidad, podemos decir que no está sesgado sino que, más bien, reproduce fielmente la “verdad fundamental injusta” que caracteriza nuestro mundo. No hay sesgo, sino precisión. Pero, de acuerdo a la definición amplia, el modelo es sesgado porque reproduce una tendencia indeseable al repetir las injusticias. La disputa entre precisión y deseo enmascara una pregunta filosófica y eminentemente ética: ¿los algoritmos deberían reproducir la sociedad con precisión o deberían contribuir a mejorarla? Y en todo caso, ¿cómo sería el mundo deseable?

La postura de Zajko es clara y esperanzadora:

El comportamiento de los sistemas digitales está escrito en código, y el código puede ser reescrito. En otras palabras, si las desigualdades están codificadas en algoritmos, software u hojas de cálculo, cambiar el código va a redistribuir las desigualdades.

Por ejemplo, este artículo de autoría múltiple que, a pesar de la imprecisión que señalo, está muy bueno.

Excelente, Pau! El otro día usé la palabra "sesgo" en un artículo. Lo voy a revisar.

Muy bueno! Mientras leía pensaba en la frase "hijos sanos del patriarcado", y es algo así, no son errores, es estadística automatizando el funcionamiento de la sociedad